L’intelligenza artificiale sembra essere divenuta un argomento pregnante della nostra società, tanto da essere anche inserita nel fitto programma del G7 che è oramai alle porte. Questa innovativa tecnologia sembra accendere interessi che si connotano di varie accezioni ai cui antipodi troviamo chi ne è fortemente entusiasta e chi invece la vede come un mostro demagogico.

È un argomento che ha coinvolto inevitabilmente anche la riflessione della Chiesa, che vi si è soffermata anche nel testo presentato per la Giornata della Pace del 1° gennaio 2024 intitolato proprio: “intelligenza artificiale e pace”.

In questo testo, come già scritto in un mio articolo di qualche tempo addietro, la Chiesa manifesta la sua consueta prudenza difronte alla presenza di una nuova tecnologia che ha potenzialità pervasive nella società, come è accaduto per la scrittura, per la radiofonia, per la televisione, per la rete internet ed ora appunto per la I.A.

Il nostro giornale può vantare uno stimabile rapporto con un intellettuale e scienziato di grande spessore, il Professore Gabriele Andreoli, esperto di intelligenza artificiale al quale ho voluto porre le domande che so essere più controverse almeno in una fascia di intellettuali legati alla Chiesa cattolica.

Professore cosa possiamo dire dell’intelligenza artificiale:

“Credo che primariamente vada definita la materia di cui stiamo parlando, proprio per fugare da principio confusioni che rischiano di imbrigliare i pensieri. Stiamo parlando di un confluire di metodologie e di sistemi, per cui è necessario innanzitutto cominciare a pensare che non ci può essere un’onniscienza perché non esiste un solo sistema centrale di cui si sappia ogni cosa. Dobbiamo percepire noi essere umani come incapaci di possedere onniscienza, in quanto noi stessi siamo un sistema adattivo complesso e al contempo siamo anche parte proprio di un sistema adattivo complesso. Per cui sotto l’ombrello definito “intelligenza artificiale” vi è la coesistenza di vari sistemi che vanno ad unirsi. La questione importante ora è definire un codice con cui possiamo condividere ed usare questa intelligenza artificiale in modo etico per il bene dell’umanità. È necessario riuscire a definire attraverso dei progetti di condivisione, di analisi, di studio, di ricerca e di sviluppo degli strumenti da mettere nelle mani dei legislatori, di coloro che gestiscono gli stati e la vita civile, per riuscire in questo modo a costruire un mondo etico e più giusto, soprattutto pensando a quante porzioni del nostro vivere, sempre maggiori, stanno acquisendo le macchine. Un esempio esplicativo è infatti dato dalla medicina, dove l’intelligenza artificiale è utilizzata per declinare le informazioni dei pazienti, per sviluppare più rapidamente degli antibiotici, per gestire le informazioni che provengono dal microbioma e per tantissime altre cose veramente affascinanti ed utili.

Fondamentale è però decidere quale sia la metodologia da adottare per assicurarci i moltissimi vantaggi che la tecnologia ci offre, cercando di minimizzare gli svantaggi potenziali di una eventuale degenerazione del sistema. Ovviamente però va considerato che noi esseri umani non siamo un sistema resiliente ma siamo comunque un sistema antifragile, perché siamo fatti di materia e, come detto, siamo un sistema adattivo complesso, per cui dobbiamo comprendere che l’errore è anche il metodo attraverso il quale poi riusciamo anche a progredire. Possiamo azzardare il paragone con la paura: dobbiamo certamente vincere la paura, ma è pur sempre una pulsione, un sentimento che dobbiamo avere per comprendere come non farci male.

Dunque, la mia riflessione, che è anche il risultato di molti incontri avuti a Davos e a COP28, mi porta a dire che dato che la tecnologia ce lo permette, ora è necessario creare dei laboratori, dei momenti di incontro, di comunione e di condivisione in cui si riesca a tracciare una strada da percorrere insieme per superare barriere e resistenze e costruire invece ponti di fratellanza, di sviluppo, di maggiore benessere e di comprensione per utilizzare al meglio quelle che sono le tecnologie che ci vengono offerte oggi. È quindi veramente indispensabile occuparsi e comprendere adesso questi sistemi, affinché non se ne occupino poi altri che potrebbero minare le infrastrutture della nostra società e soprattutto potremmo rischiare, non occupandocene ora, di lasciare i giovani in balia di un mondo che non siamo più in grado di gestire né di controllare e neanche più di indirizzare le giovani generazioni”.

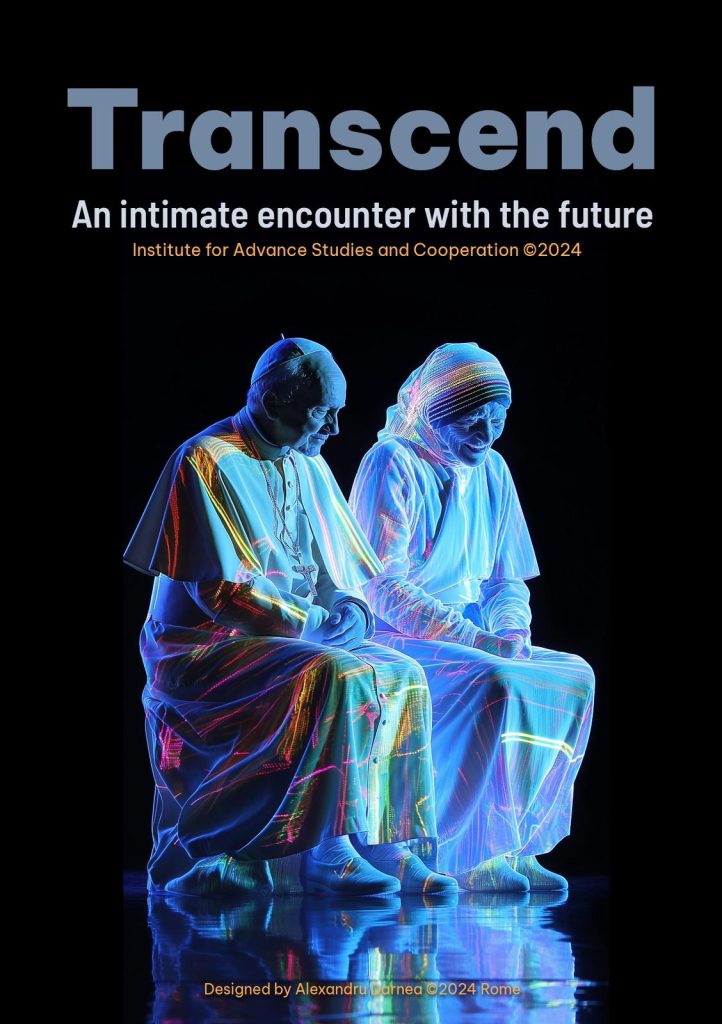

Professor Andreoli sono forti le perplessità per quanto concerne l’uso della intelligenza artificiale soprattutto nella Chiesa e taluno è anche molto perplesso circa il progetto, che io trovo abbia una forte valenza evangelizzatrice, a cui lei ha dato il nome di Transcend , che fa uso di questa nuova tecnologia. Quali riflessioni possiamo fare per aiutare a comprendere il potenziale di tutto ciò?

“Non credo ci sia una ricetta. Deve essere sempre la nostra buona fede e la nostra etica a guidarci. Dobbiamo ringraziare il Signore che ci ha donato il libero arbitrio, ossia la possibilità di scegliere e anche la capacità di trovarci difronte alla paura e avere il coraggio di superare gli ostacoli.

Noi esseri umani dobbiamo essere a servizio, la nostra straordinarietà è che siamo un “unicum” e al contempo parte di un insieme. E anche la nostra amata Chiesa è un sistema adattivo complesso ed è abitata da uomini. Tra noi uomini ci sono quelli che lasciano la loro impronta nel modo ed altri che invece dimenticheremo.

Per quanto concerne Transcend so che la perplessità che taluni vedono nel voler creare due avatar responsive che ripresentano la personalità di Santa Madre Teresa di Calcutta e di San Giovanni Paolo II, riguardano il fatto di un timore che sia una sorta di volontà di “riportare in vita” qualcuno. Ma assolutamente questo progetto non è il sogno di Frankenstein, non è il voler ricreare qualcosa che non ha motivo di essere. La finalità di questa idea è invece esattamente, attraverso un progetto di studio e di ricerca, rendere due avatar il più realistici possibile, ma non reali. Non vogliamo ricreare i due Santi, ma vogliamo creare due avatar che siano espressivi di quella vita, di quella missione e di quell’insegnamento. È molto importante che non si confonda il voler fare un progetto di ricerca su queste figure di Santi, con il voler ricostruire realmente queste figure dal punto di vista umano. Noi stiamo studiando e operando affinché questi due avatar siano in grado di dialogare tra loro con i contenuti che avevano i loro discorsi quando erano nella loro vita terrena e che siano tra l’altro in grado di rispondere a domande dei fedeli in modo anche adeguato a seconda di come venga posta loro la domanda”.

Gabriele Andreoli la tecnologia e, nello specifico, l’intelligenza artificiale è buona o cattiva?

“Dipende come viene usata. Certo non vorremmo usare la tecnologia per cose che siano offensive, ma torniamo al discorso che sono gli uomini ad avere la responsabilità ed il libero arbitrio per poter utilizzare questi mezzi. L’unico modo affinché le scelte che derivano da questa libertà umana siano etiche è quello di insegnare alle persone ciò che stanno facendo e quello che stanno usando. Difatti se le dittature mettono le armi in mano a dei ragazzini, essi stessi diventano delle armi micidiali, perché non hanno la capacità etica di comprendere quello che è la vita, poiché sono manipolati ed influenzati per utilizzare queste armi in maniera spietata. Questo discorso vale anche per la tecnologia. Se non ci assumiamo la responsabilità di lavorare per condividere la tecnologia, questa stessa tecnologia può diventare anche maligna.

Mi piace riflettere e vorrei che tutti riflettessimo sul fatto che l’abbraccio di San Pietro, del Bernini all’umanità stia a dirci proprio che la Chiesa è presente per un abbraccio grande di condivisione. Non comprendo infatti come possiamo scindere la nostra fede da quello che facciamo”.

Leave a Reply